-

NEC T110k Xeon4C/8G/2TB*2/R1/W22 NP8100-2902YQ1Y

-

【中古】(非常に良い)Aja pak1000?1tb SSDモジュール、Ki Pro Quad (pak1000?)

-

日本ヒューレット・パッカード 128GB 4Rx4 PC5-5600B-R 3DS Smart Memory(P64709-B21) 取り寄せ商品

-

コーセル■品名記号:KHNA90F-12□電源 KHNAシリーズ□定格入力85-264VAC 1Φ□定格出力電力:90W□出力電圧:12V□オプション:-□推奨ノイズフィルタ NAC-04-472 NAC-04-472-D

-

HP DL360G10 S4215R 1P8C 32G 8SFF S100i NCGS P40409-291

-

【中古】(非常に良い)ELSA NVIDIA Quadro P4000 グラフィックスボード VD6268 EQP4000-8GER

-

U-Reach Japan 40ポート SDデュプリケータ Intelligent 9 Silver SD940S 1:39のコピーおよび最大40枚のSDカードの同時消去が可能。転送速度33MB/ 秒

-

Lenovo 4X67A72593 NVIDIA A40 48GB PCIe 4.0 GPU (パッシブ冷却)

-

【中古】【未使用】ELSA NVIDIA Quadro P6000 グラフィックスボード VD6177 EQP6000-24GER

10%ポイントバック

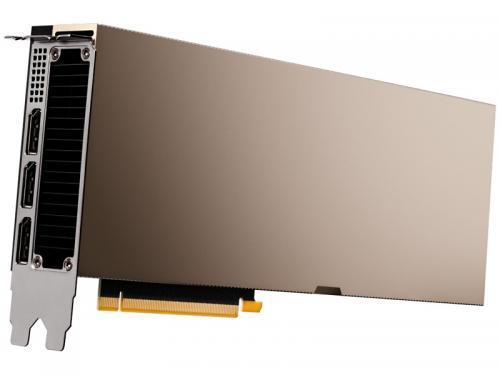

NVIDIA NVH100-80G [グラフィックボード]

- 1~2日で出荷可能

カラー名は、ショップ提供情報に基づいています。モデル画像は着用イメージとなります。色味は生地アップでご確認ください。画面設定等により実際の商品の色とは異なって見える場合がございます。

オススメのアイテムあなたにおすすめのアイテム

-

10%ポイントバック

エバラ EVM型ステンレス製立型多段ポンプ 60Hz 口径125mm ( 125EVM2645R ) (株)荏原製作所 ¥2,495,440

10%ポイントバック

エバラ EVM型ステンレス製立型多段ポンプ 60Hz 口径125mm ( 125EVM2645R ) (株)荏原製作所 ¥2,495,440 -

10%ポイントバック

【ポイント3倍★1日限定】【最大15,000円OFFクーポン】【ローン24回払い無金利】 その他 マイアミキューバンチェーン ブレスレット - - レディース K18イエローゴールド ブレスレット Aランク 中古 銀蔵 ¥2,530,000

10%ポイントバック

【ポイント3倍★1日限定】【最大15,000円OFFクーポン】【ローン24回払い無金利】 その他 マイアミキューバンチェーン ブレスレット - - レディース K18イエローゴールド ブレスレット Aランク 中古 銀蔵 ¥2,530,000 -

10%ポイントバック

新品【適格請求書◆税込】◆富士電機 Fuji Electric インバータ FRN55F1S-4J◆6ヶ月保 ¥2,567,040

10%ポイントバック

新品【適格請求書◆税込】◆富士電機 Fuji Electric インバータ FRN55F1S-4J◆6ヶ月保 ¥2,567,040 -

10%ポイントバック

45馬力トラクター【GM451BZ】 ¥2,510,992

10%ポイントバック

45馬力トラクター【GM451BZ】 ¥2,510,992 -

10%ポイントバック

【送料別途】【直送品】オリオン 精密空調機器 PAP温湿度制御タイプ(空冷式) PAP10A1-K ¥2,002,483

10%ポイントバック

【送料別途】【直送品】オリオン 精密空調機器 PAP温湿度制御タイプ(空冷式) PAP10A1-K ¥2,002,483 -

10%ポイントバック

テラル ラインポンプ【LPE200J-690-e】60Hz 三相200V 鋳鉄製 2極/4極 LPE型〔HC〕 ¥1,762,053

10%ポイントバック

テラル ラインポンプ【LPE200J-690-e】60Hz 三相200V 鋳鉄製 2極/4極 LPE型〔HC〕 ¥1,762,053 -

10%ポイントバック

(株)荏原製作所 エバラ イドボーイ BHS型深井戸水中モータポンプ 50Hz 口径125mm 出力55kW 125BHSJ5555 (1343727) ¥2,518,118

10%ポイントバック

(株)荏原製作所 エバラ イドボーイ BHS型深井戸水中モータポンプ 50Hz 口径125mm 出力55kW 125BHSJ5555 (1343727) ¥2,518,118 -

10%ポイントバック

###エバラ/荏原 【150×125FS4N690E】片吸込渦巻ポンプ FS型 標準仕様 メカニカルシール形 出力90kW 4極 三相 モーター駆動 60Hz〔GA〕 ¥2,463,003

10%ポイントバック

###エバラ/荏原 【150×125FS4N690E】片吸込渦巻ポンプ FS型 標準仕様 メカニカルシール形 出力90kW 4極 三相 モーター駆動 60Hz〔GA〕 ¥2,463,003 -

10%ポイントバック

【3種選べるクーポン 2/17~】【ローン60回払い無金利】【中古】 ロレックス ROLEX コスモグラフ デイトナ 116503G ランダムシリアル ブラック/ダイヤモンド メンズ 腕時計 ロレックス 時計 高級腕時計 ブランド ¥1,957,120

10%ポイントバック

【3種選べるクーポン 2/17~】【ローン60回払い無金利】【中古】 ロレックス ROLEX コスモグラフ デイトナ 116503G ランダムシリアル ブラック/ダイヤモンド メンズ 腕時計 ロレックス 時計 高級腕時計 ブランド ¥1,957,120 -

10%ポイントバック

【極美品/品質保証書付】 アンティークコイン 金貨 1858-P LIBERTY GOLD EAGLE $10 DOLLAR COIN NGC XF-40 2521 MINTAGE RICHMOND COLLEC [送料無料] #gct-wr-011000-8183 ¥2,474,500

10%ポイントバック

【極美品/品質保証書付】 アンティークコイン 金貨 1858-P LIBERTY GOLD EAGLE $10 DOLLAR COIN NGC XF-40 2521 MINTAGE RICHMOND COLLEC [送料無料] #gct-wr-011000-8183 ¥2,474,500

PCパーツ・ベストランキング PCパーツ・ベストランキング

-

1

![FORTINET [FG-100F-BDL-FC] FortiGate100F UTMプロテクション版](https://tshop.r10s.jp/tt-mall/cabinet/synnex01/ft9038y.jpg) FORTINET [FG-100F-BDL-FC] FortiGate100F UTMプロテクション版 ¥436,957

FORTINET [FG-100F-BDL-FC] FortiGate100F UTMプロテクション版 ¥436,957 -

2

AMD Threadrpr PRO 7975WX w/o cooler CPU お取り寄せ【新品】 ¥422,400

AMD Threadrpr PRO 7975WX w/o cooler CPU お取り寄せ【新品】 ¥422,400 -

3

【新品/取寄品/代引不可】ThinkStation P7/w7-3465X/64GBMem/3072GB/CPU内蔵/Win11 Pro for Workstations 30F2000DJP ¥1,095,551

【新品/取寄品/代引不可】ThinkStation P7/w7-3465X/64GBMem/3072GB/CPU内蔵/Win11 Pro for Workstations 30F2000DJP ¥1,095,551 -

4

HPE P41403-B21 HPE 3.84TB NVMe Gen4 High Performance Read Intensive SFF BC Self-encrypting FIPS U.3 CM6 SSD ¥572,603

HPE P41403-B21 HPE 3.84TB NVMe Gen4 High Performance Read Intensive SFF BC Self-encrypting FIPS U.3 CM6 SSD ¥572,603 -

5

![ENQR6000A-48GER ELSA [グラフィックボード(PCIExp 48GB)]](https://tshop.r10s.jp/premoa/cabinet/pics/472/4524076071499.jpg) ENQR6000A-48GER ELSA [グラフィックボード(PCIExp 48GB)] ¥755,892

ENQR6000A-48GER ELSA [グラフィックボード(PCIExp 48GB)] ¥755,892 -

6

【送料無料】P50216-B21 HPE 1.92TB NVMe Gen4 High Performance Read Intensive SFF BC U.3 PM1733a SSD【在庫目安:お取り寄せ】 ¥337,592

【送料無料】P50216-B21 HPE 1.92TB NVMe Gen4 High Performance Read Intensive SFF BC U.3 PM1733a SSD【在庫目安:お取り寄せ】 ¥337,592 -

7

HPE P53554-B21 HPE 20TB SATA 6G 7.2K LFF LP 512e Helium ISE MV HDD ¥252,355

HPE P53554-B21 HPE 20TB SATA 6G 7.2K LFF LP 512e Helium ISE MV HDD ¥252,355 -

8

HP(Enterprise) DL360 G11 S4410Y 1P12C 32G 4LFF VROC P60735-291 ¥804,130

HP(Enterprise) DL360 G11 S4410Y 1P12C 32G 4LFF VROC P60735-291 ¥804,130 -

9

HP(Enterprise) DL20G10+ E-2336 1P6C 16G 4SFF VROC RPS P44115-291 ¥343,017

HP(Enterprise) DL20G10+ E-2336 1P6C 16G 4SFF VROC RPS P44115-291 ¥343,017 -

10

HPE P49598-B21 XeonG 6426Y 2.5GHz 1P16C CPU for Gen11 ¥320,823

HPE P49598-B21 XeonG 6426Y 2.5GHz 1P16C CPU for Gen11 ¥320,823

![NVIDIA NVH100-80G [グラフィックボード]](https://tshop.r10s.jp/a-price/cabinet/pics/675/2-2980000404801.jpg)

![NVIDIA NVH100-80G [グラフィックボード]](https://tshop.r10s.jp/a-price/cabinet/pics/675/3-2980000404801.jpg)

![NVIDIA NVH100-80G [グラフィックボード]](https://tshop.r10s.jp/a-price/cabinet/pics/675/2980000404801.jpg)